TinyTL: Reduce Activations, Not Trainable Parameters for Efficient On-Device Learning

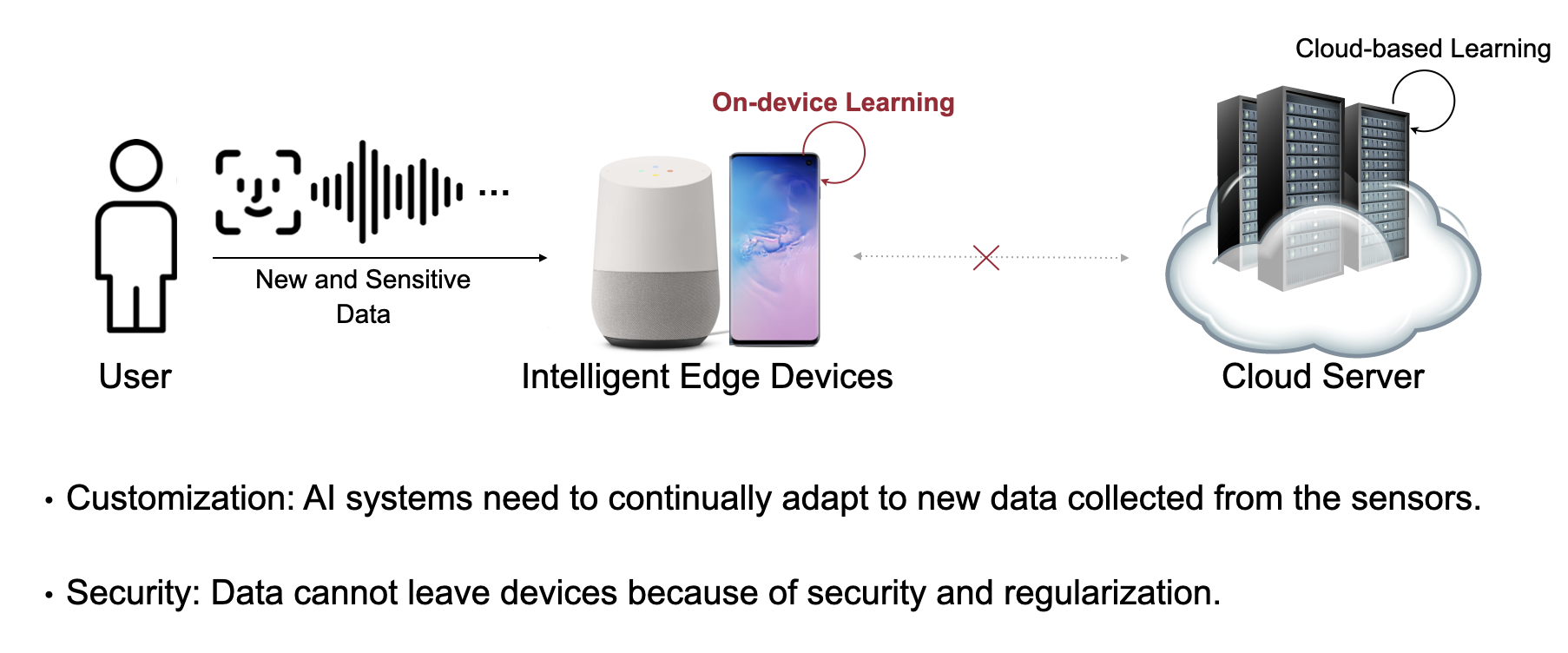

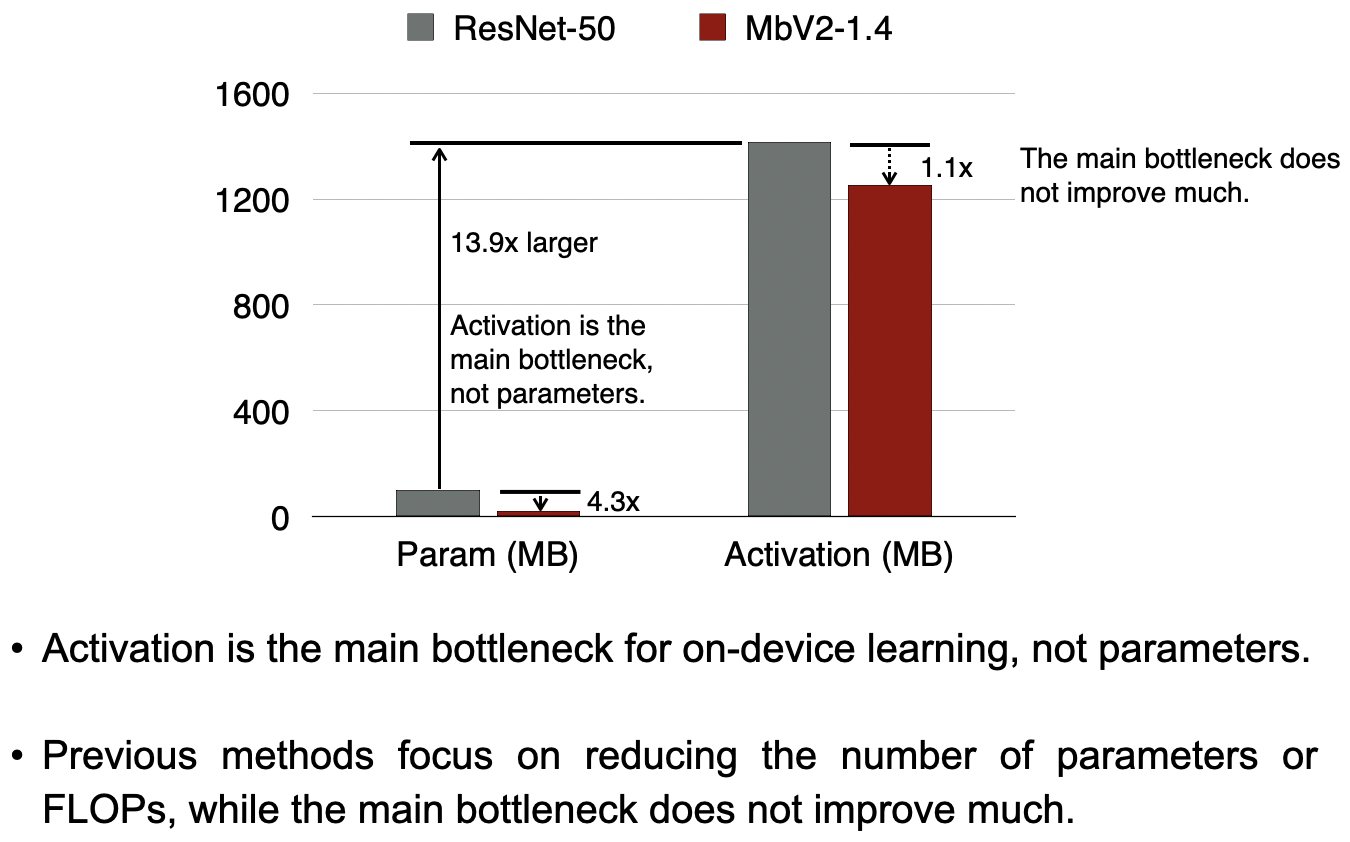

主要讲终端设备学习,边缘设备持续接受新数据,让AI模型适应新数据,但是只能用一小部分内存去适应边缘设备有限的内存空间。现有的工作通过减少训练参数来解决这个问题。但是这没有直接转为对内存的节省,因为现在的瓶颈已经不在于参数,而是Activation。

为了维持这个适应能力,我们介绍了一种全新的内存高效的偏置模块——lite residual module,通过学习小的残余特征图用来提炼特征提取器,而这仅仅使用了3.8%的额外存储。大量实验表明TinyTL重显著节省了内存(最高可至6.5倍),代价仅为相较于fine-tuning整个网络很小的精度损失。TinyTL实现了显著的精度提升(相较于去年的fine-tuning最高提升了34.1%)。结合上适应特征提取器,TinyTL节省了7.3-12.9倍的存储空间,相对于fine-tuning整个Inception-V3.